Redes P2P: El proyecto inconcluso de una red abierta

Internet y las redes P2P

Internet suele ser descrito de manera que pareciera ser un sinónimo de apertura, acceso y libertad, como si fuera una tecnología que inequívocamente es capaz de influir, por sí misma, mayor transparencia y empoderamiento de los usuarios. Por estas razones, las empresas ligadas a internet pretenden también ser representantes de dichos valores. Google declara que su misión es “organizar la información del mundo y hacer que sea útil y accesible para todos”1. Facebook, por su parte, afirma que su objetivo es “conectar a personas y empresas de todo el mundo y hacerlo con responsabilidad”2. Sin embargo, internet no ha sido construido teniendo en cuenta la libertad y la colaboración, ni las empresas asociadas a la red trabajan por hacer reales estos valores presuntos3. Muy por el contrario, la forma actual de internet, tanto por su arquitectura técnica como por las relaciones económicas y políticas que la sostienen, tiende fuertemente a una organización centralizada y, como efecto de ello, a opacar otras formas posibles de comunicación en red que la tecnología permite. Esta centralización no consiste en que exista un único lugar de control o una única corporación, sino que es más bien una arquitectura de comunicación que favorece la progresiva concentración de poder en torno a los recursos y capacidad de decisión sobre la red, lo que se podrá ver más adelante al revisar la historia de internet. En la medida en que crece, la arquitectura de una red no sólo define cómo funciona internamente, sino que también reduce el campo de existencia para otras redes posibles; de manera que la tendencia a la centralización conlleva la paulatina disolución de formas más descentralizadas de conexión. Una red descentralizada, por ejemplo, son las redes de pares o P2P, que implican una participación colectiva en cómo se organiza la comunicación en línea.

Para entender la diferencia entre las redes P2P y las que predominan actualmente, comparamos cómo se estructuran. La arquitectura de red que prima en la actualidad funciona principalmente bajo la lógica de cliente/servidor. Esto quiere decir que la mayoría de los programas o aplicaciones que usamos en nuestros dispositivos cumplen la función de un cliente que solicita un servicio a otro dispositivo, razón por la cual a las máquinas que entregan este servicio se les llama “servidores”. Por ejemplo, al escuchar música en Spotify o ver un video en Youtube, nuestros dispositivos usan una aplicación o navegador que cumple la función de cliente que solicita o «consume» los servidores de esas empresas, aplicando, con ello, la lógica cliente/servidor. En cambio, con las redes P2P ocurre algo muy distinto. P2P es un acrónimo de la expresión en inglés peer to peer -en español, de par a par o de igual a igual-, que consiste en una arquitectura de comunicación que, como indica su nombre, establece conexiones entre pares. En una red de pares, cada dispositivo puede simultáneamente conectarse a otros para conseguir la información que busca y también entregar la información a otros dispositivos que lo soliciten, es decir, cumple tanto la función de “cliente” como de “servidor”, como ocurre con la descarga de torrents. La lógica que está en la base de la arquitectura P2P es crear y mantener redes fuertemente descentralizadas, en donde el control de la información esté distribuido entre todos los usuarios conectados, sin depender de un único grupo de dispositivos o computadores que controlen la información o la conexión. En las redes P2P, el único protocolo que articula la red es la colaboración.

Con el auge de las grandes plataformas web, las redes sociales convencionales y los servicios de streaming, hemos perdido de vista la capacidad que tenemos de convertir las redes digitales en un intercambio colaborativo en vez de usarlas sólo como una búsqueda de servicios. De hecho, a pesar de que la forma en que se organiza la topología -o conectividad- de internet, existen maneras de forzar su uso a modalidades colaborativas y descentralizadas, como es el caso de las redes P2P, que podemos utilizar a pesar de las restricciones tecnológicas y económicas que atraviesan internet.

El motivo por el cual internet llegó a ser una red predominantemente de tipo cliente/servidor en vez de una red de pares se puede comprender en su historia, que a pesar de ser relativamente reciente, es un claro ejemplo de cómo las fuerzas políticas y económicas dan existencia y forma a las tecnologías que usamos.

Armas y cables: una historia breve de internet

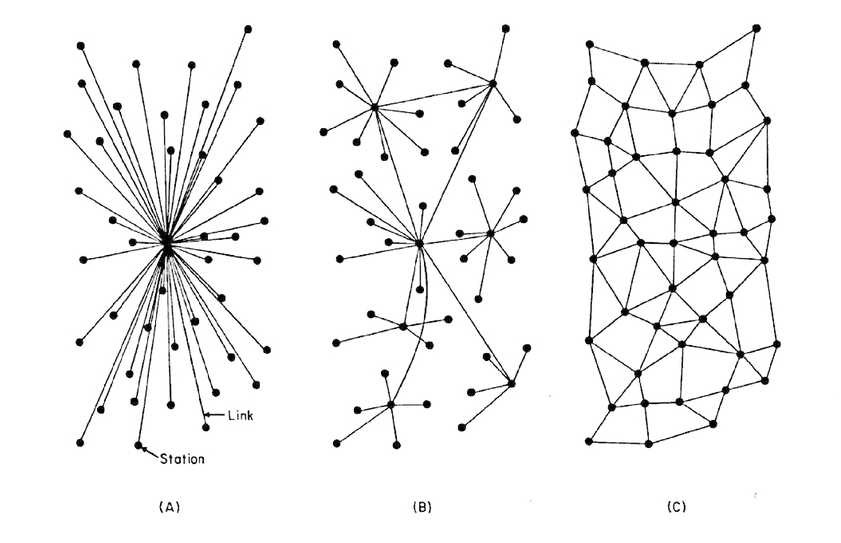

Antes de atraparse en el ritmo homogéneo y vacío de las redes sociales y el marketing digital, internet tuvo una historia. Como todo el desarrollo tecnológico de la segunda mitad del siglo XX, se inicia en el contexto de la guerra fría, cuando en 1962 la RAND Corporation, el laboratorio de investigación y desarrollo de las Fuerza Aérea estadounidense, le pidió a Paul Baran que diseñara una red capaz de soportar un ataque nuclear. Baran elaboró un diagrama con tres tipos redes: las redes centralizadas (A), que dependen de un único nodo o “servidor”, las redes descentralizadas (B), que tiene más de un nodo, y las redes distribuidas ( C), en donde todos los puntos de conexión de la red son también todos los nodos de interconexión de los demás. La idea de Baran era construir una red lo más descentralizada posible en donde hubiese tantos puntos de interconexión que, en caso de pérdida de un punto, un mensaje pudiese llegar a su destino buscando más de una ruta posible.

No obstante, la única empresa de telecomunicaciones estadounidense de ese entonces, la AT&T, no quiso arriesgarse a modificar su modelo centralizado de comunicaciones, por lo que la propuesta de Baran fue desestimada. Aun así, de manera posterior e independiente, por encargo del Departamento de Defensa estadounidense, se creó ARPANET, en la Universidad de California, también con el objetivo declarado de mantener el mando militar en caso de un ataque nuclear. ARPANET, que se había desarrollado con un presupuesto bajo,, también fue ofrecida por los organismos militares a la AT&T, ya que preferían usar la red como un servicio en vez de un desarrollo propio. De igual manera, la empresa consideró que el proyecto era incompatible con sus negocios. Curiosamente, este desinterés de las empresas por la incipiente red permitió que pudiera crecer con ciertas características de acceso y colaboración que aún mantiene. Además, esto también permitió incluso que surgieran redes fuera de los ambientes militares con mayores grados de apertura, como fue la red USENET.

Sin embargo, con el paso del tiempo, la creciente interconexión de los proyectos de redes universitarias y militares fueron dando forma una red unificada, condición que despertó el interés comercial en ella. Luego de la promulgación de la Ley de Telecomunicaciones en EEUU el año 1996, internet fue expuesta sin delimitaciones para su comercialización y privatización, lo que produjo un auge de empresas dedicadas a la red. Como parecía ser un mercado sin límite, ocurrió lo que pasa periódicamente en el capitalismo: se invierten capitales en infraestructuras, productos y servicios bajo la expectativa de vender; pero luego de un tiempo la demanda de los productos es menor de lo que el capital ha producido, irrumpiendo una crisis debido al exceso de producción. Al estallar la denominada “Burbuja Puntocom” en 2001, sólo el 5% de toda la fibra óptica instalada estaba en uso. La quiebra masiva de las empresas asociadas a internet generó un límite para el mercado sobre cómo obtener ganancias de internet, pero a su vez produjo una elevada concentración del capital sobreviviente en pocas empresas. El internet actual es heredero de esta concentración, no sólo porque la lógica del mercado y sus contradicciones ha llevado a un progresivo monopolio del control privado sobre la infraestructura que entrega los servicios más usados, sino que también el tráfico y almacenamiento de datos en internet está concentrado y controlado por unas cuantas empresas, como Equinix o Amazon4. Del mismo modo, la concentración privada también supone una concentración geográfica, por ejemplo, hoy el 70% del tráfico de internet pasa por Tysons Corner, en Estados Unidos.

Tras este período de concentración de capital -principalmente materializado en infraestructura-, el mercado de internet buscó una nueva manera de hacer negocios, orientando parte de su esfuerzo en la venta de contenidos en línea, como la distribución de música y entretenimiento, pero los vestigios de las redes colaborativas que aún sobrevivían sobre las infraestructuras comerciales eran un impedimento para el capital. Desde 1999 existía Napster, que fue el primer sistema P2P para el intercambio masivo de archivos y que llegó a tener 26 millones de usuarios. Sin embargo, en 2001 la persecución jurídica decretó su cierre bajo denuncia de “violaciones de derechos de autor”. Cabe señalar que Napster no almacenaba ningún contenido, sino que sólo reunía las listas de los archivos que permitían que las redes de pares intercambiaran esos archivos. El problema de fondo para el capital es que al existir redes P2P se promueve una «cooperación de la abundancia», en donde todos los usuarios pueden dar y recibir sin limitaciones. En cambio, un mercado capitalista, para poder vender contenidos culturales, necesita simular una «escasez de producción cultural», es decir, que no sea posible compartir contenidos colaborativamente, sino sólo por medio de venta y consumo.

No obstante, desde el cierre de Napster hasta la fecha, la comercialización de los contenidos que circulan en internet no ha ocurrido porque la centralización de los servicios de internet fuese más eficiente. Todo lo contrario: las redes P2P son menos costosas ya que distribuyen entre todos los pares el uso de dispositivos y ancho de banda. Tampoco ha ocurrido porque se haya logrado erradicar las redes de pares, las cuales, a pesar de ser siempre consideradas un objetivo en cada reforma de los derechos de autor, siguen funcionando, aunque de manera marginal. La forma en cómo internet llegó a ser un grupo de corporaciones se debe a que finalmente se encontró la manera de comercializar la creatividad colectiva. Dmytri Kleiner sostiene que lo que lograron hacer plataformas como Google o Facebook fue usar la infraestructura que tenían, y que acumularon, para ofrecer servicios gratuitos y fáciles de usar, principalmente para quiénes no contaban con conocimientos técnicos. En estas plataformas, los usuarios pueden crear contenidos que luego son comercializados, principalmente por medio de la publicidad. Es decir, apropiación privada de la creatividad colectiva. Una vez habituados a esta nueva infraestructura corporativa, tiene cabida el surgimiento de servicio de «streaming» de pago, como Netflix y Spotify, que han llegado a naturalizar que la producción cultural es un servicio prestado o arrendado, perteneciente sólo a las empresas, haciendo que gran parte de internet se convierta en un servicio de préstamo de información y productos culturales.

A pesar de que contamos con la tecnología suficiente para que los conocimientos y la producción cultural pueda crearse y circular de manera cooperativa, sin restricciones comerciales ni jurídicas, el internet actual, desarrollado en estas condiciones históricas, se ha convertido en un impedimento para la realización del proyecto de una red abierta que una vez prometió ser. Lo que hemos ganado en conectividad dentro de plataformas corporativas lo hemos perdido en autonomía colectiva.

Sintonizando un canal para la subversión

Ventajas de las redes descentralizadas

Las redes descentralizadas, y en particular las redes P2P, son un primer paso para la autonomía tecnológica, ya que a pesar de la estructura actual de internet, es aún posible hacer funcionar redes de pares para establecer comunicaciones y compartir archivos de manera colaborativa. Las razones por las cuales estas redes permiten una mayor autonomía podrían resumirse en cuatro elementos.

Colectivización

Las redes P2P son una colectivización completa de los recursos de la red, desde el compartir el ancho de banda hasta el almacenamiento de los archivos. Sin tener que depender de servidores únicos o empresas, las redes de pares ponen en común toda la creatividad y la propiedad de qué se publica y comparte en ellas. De hecho, las redes de pares, a diferencia de lo que ocurre con los servicios centralizados, mejoran su funcionamiento y rapidez mientras más usuarios hayan en la red, ya que la colaboración potencia su capacidad.

Adaptabilidad

Como las redes descentralizadas, y en particular las redes P2P, no dependen de un único servidor o empresa que las mantenga en línea, pueden adaptarse y sobrevivir a escenarios adversos, como catástrofes naturales o a la censura, ya que una vez puesto en común los contenidos o los enlaces de comunicación, no existe un único dispositivo o plataforma que al inhabilitarse o censurarse impida que la red siga comunicándose y compartiendo. Por estas razones, organizaciones como Wikileaks mantienen siempre sus filtraciones en las redes de torrent, de forma que sea imposible impedir su circulación. El listado completo de archivos puede encontrarse aquí https://file.wikileaks.org/

Escalabilidad

El alcance que puede tener una red de pares no tiene un límite definido, salvo por la cantidad de usuarios que la utilizan (A diferencia de un servidor que está siempre limitado por su infraestructura física). Un archivo compartido por un usuario, por ejemplo, puede beneficiar a todos quienes usan la red, de manera que cada acción permite beneficiar a todos por igual, sin importar desde qué lugar estén conectados. Las redes P2P pueden permitir un intercambio libre y gratuito entre iguales para toda la humanidad conectada.

Bajo Costo

Mantener un servicio de almacenamiento y distribución en línea supone un coste considerable para la mayoría. En cambio, en las redes P2P el costo y los recursos se comparten entre todos los integrantes de la red al distribuir el almacenamiento y velocidad de transmisión.

Dentro de un horizonte de autonomía tecnológica, podemos alterar la lógica de cómo circula la información y ponerla al servicio de los intereses comunitarios. Una manera de empezar es promover el uso del P2P y colectivizar la información, el conocimiento y la producción cultural. Todo la creatividad es colectiva, por lo que su acceso también debe serlo.

Ejemplos de redes P2P

Algunos ejemplos actuales de programas o plataformas que funcionan como redes P2P son los siguientes

BitTorrent: Protocolo de intercambio distribuido de archivos, más conocido como «Torrent». Permite compartir archivos sin restricciones y existen varios sitios destinados a mantener listas de archivos disponibles para descargar. Entre los programas para usar torrent, destaca Transmission por la facilidad de uso.

Jami: Sistema de chats de audio que no depende de ningún servidor. Cuenta con aplicación para teléfonos móviles y dispositivos de escritorio. Cuenta con cifrado de extremo a extremo. Enlace.

Briar: Sistema de mensajería descentralizado para teléfonos móviles que incluso puede funcionar a través de la red de anonimato Tor y de Bluetooth entre dispositivos cercanos. Cuenta con cifrado de extremo a extremo. Enlace.

Retroshare: Plataforma de mensajería e intercambio de archivos. Puede instalarse y usarse en múltiples plataformas. Cuenta con cifrado de extremo a extremo. Enlace.

Freenet: Red de navegación anónima, similar a Tor, exceptuando que en esta red no existen servidores que canalicen el tráfico, sino que el contenido de la red se distribuye entre todos los dispositivos conectados. Es una red independiente a internet, por lo que sólo es accesible desde el programa que permite su acceso. Enlace.

Referencias

Generales:

Marta Peirano. «Infraestructura», en El Enemigo Conoce el Sistema. (2019).

Dmytri Kleiner. «Atrapados en la telaraña mundial», en Manifiesto Telecomunista. (2013).

Fuentes: